Вот как Google улучшил портретный режим на Pixel 4

Google Pixel 4 является первым Pixel устройство с более чем одной камерой заднего вида, маркировка давно назревшую шаг для компании в то время, когда тройные камеры, как ожидается.

Google смог творить чудеса с телефонами Pixel с одной камерой, особенно с портретным режимом, для которого традиционно требуется вторая задняя камера. Теперь компания обратилась в свой блог AI, чтобы объяснить, как портретный режим Pixel 4 улучшает ситуацию.

Оказывается, Pixel 4 по- прежнему использует ту же технологию портретного режима с одной камерой, что и предыдущие Pixel. В более старых телефонах для портретного режима использовалась технология двухпиксельной автофокусировки, при которой каждый пиксель на основной камере 12 МП делился пополам. Каждая половина пикселя камеры видит немного другую точку обзора (особенно на заднем плане). Это позволяет грубо оценить глубину путем нахождения соответствующих пикселей между двумя точками обзора.

Однако это решение имеет свои ограничения, отмечает Google в блоге, поскольку двойные пиксели ограничены крошечной единственной камерой. Это означает, что разница между точками обзора чрезвычайно мала, и вам действительно нужны более широкие точки обзора для лучшей оценки глубины.

Google открывает телеобъективы

Именно здесь в игру вступает телеобъектив Pixel 4, поскольку Google отмечает, что расстояние между основной и телеобъективом составляет 13 мм. Google показывает разницу между тем, что видят двойные пиксели, и тем, что видят двойные камеры, на GIF-изображении ниже. Обратите внимание, как есть небольшой вертикальный сдвиг с двумя пикселями (L), в отличие от очень заметного смещения с двумя камерами.

Двойные камеры действительно представляют одну серьезную проблему в этом отношении, поскольку пиксели в одном виде могут не быть найдены в другом (из-за более широких точек обзора). Вот почему Google не отказывается от устаревшего подхода к портретному режиму на Pixel 4.

«Например, пиксели фона непосредственно справа от человека на изображении с основной камеры не имеют соответствующего пикселя на изображении с дополнительной камеры. Таким образом, невозможно измерить параллакс для оценки глубины этих пикселей при использовании только двух камер », – говорится в отрывке из блога AI. «Однако эти пиксели все еще можно увидеть на двухпиксельном просмотре (слева), что позволяет лучше оценить глубину в этих областях».

Тем не менее, двойные камеры также помогают справиться с так называемой проблемой диафрагмы, которая усложняет оценку глубины вертикальных линий. Кроме того, Google также обучил свою нейронную сеть достаточно хорошо вычислять глубину, когда доступен только один метод (двойной пиксель или две камеры). Компания заявляет, что в телефоне используются оба метода отображения глубины, когда камера находится на расстоянии не менее 20 см от объекта (минимальное расстояние фокусировки для телеобъектива).

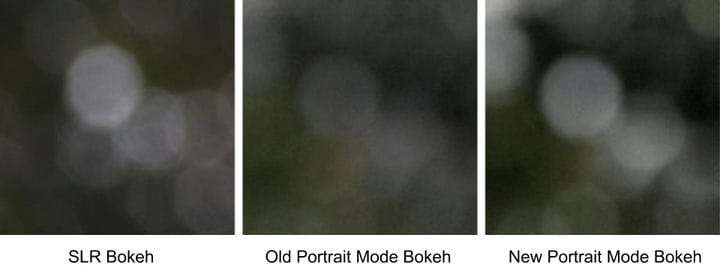

Наконец, Google говорит, что это также помогло сделать боке более заметным, чтобы вы могли более четко видеть диски боке на фоне кадра. Посмотрите изображения выше, чтобы лучше представить готовый продукт.

Сейчас это не единственная новая технология на телефонах Google Pixel, поскольку компания ранее подробно рассказывала, как работает ее режим астрофотографии. В любом случае, мы надеемся, что Google продолжит расширять границы вычислительной фотографии в 2020 году.

Источник записи: https://www.androidauthority.com